Den digitalen Bildsensor verstehen

Unabhängig von der Einteilung bleibt die Aufgabe gleich: einfallendes Licht (Photonen) in ein elektrisches Signal umzuwandeln, das angezeigt, analysiert oder gespeichert werden kann. Bildsensoren sind Halbleiterbausteine und eine der wichtigsten Komponenten einer Machine-Vision-Kamera. Jährlich kommen neue Sensorgenerationen mit Verbesserungen bei Größe, Auflösung, Geschwindigkeit und Lichtempfindlichkeit. In diesem Beitrag erläutern wir grundlegende Sensortechnologien in Machine-Vision-Kameras und ihren Bezug zu den gängigen Klassifizierungen.

Inhaltsverzeichnis

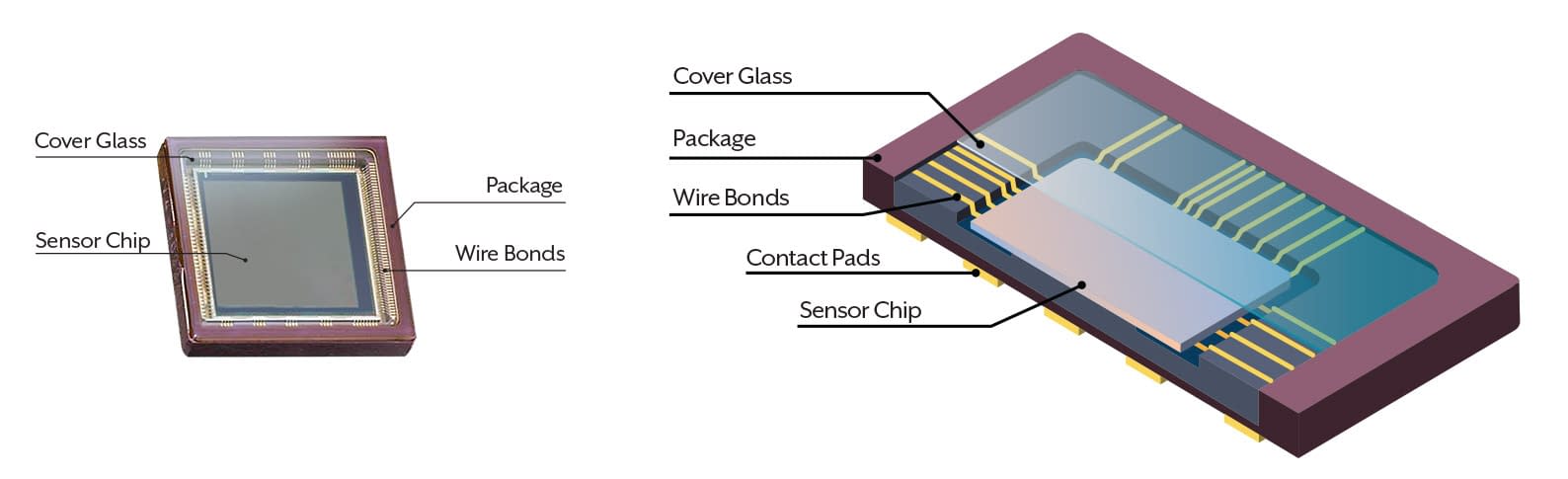

Aufbau eines Bildsensors

Die Abbildung zeigt einen typischen CMOS-Bildsensor. Der Chip sitzt in einem Gehäuse mit Schutzglas. Kontaktflächen verbinden den Sensor mit der Leiterplatte.

Hinweis

Sensoren werden in unterschiedlichen Gehäusen angeboten. Das Foto zeigt ein Keramik-PGA-Gehäuse.

Oben: Schematische Darstellung eines CMOS-Bildsensors

Der Halbleiterchip enthält Pixel mit lichtempfindlichen Elementen, Mikrolinsen und Mikroelektronik. Die Chips werden von Halbleiterherstellern gefertigt und aus Wafern vereinzelt. Bonddrähte übertragen das Signal vom Die zu den Kontaktflächen. Das Gehäuse schützt Chip und Bonddrähte, sorgt für Wärmeabfuhr und bildet die elektrische Schnittstelle. Eine transparente Abdeckung vor dem Sensor schützt die Struktur und lässt Licht auf die aktive Fläche.

Silizium-Wafer für Bildsensoren

Sensor-Dies werden in großen Stückzahlen auf Silizium-Wafern produziert. Nach dem Vereinzeln enthält jedes Teil einen Sensor-Die. Größere Dies ergeben weniger Sensoren pro Wafer und erhöhen in der Regel die Kosten. Einzeldefekte auf dem Wafer treffen große Bildsensoren mit höherer Wahrscheinlichkeit.

Oben: Sensor-Dies werden präzise aus dem Wafer geschnitten</blockquote]

Hinweis

![]() Vom Roh-Wafer bis zum einzelnen Sensor vergehen häufig mehrere Monate.

Vom Roh-Wafer bis zum einzelnen Sensor vergehen häufig mehrere Monate.

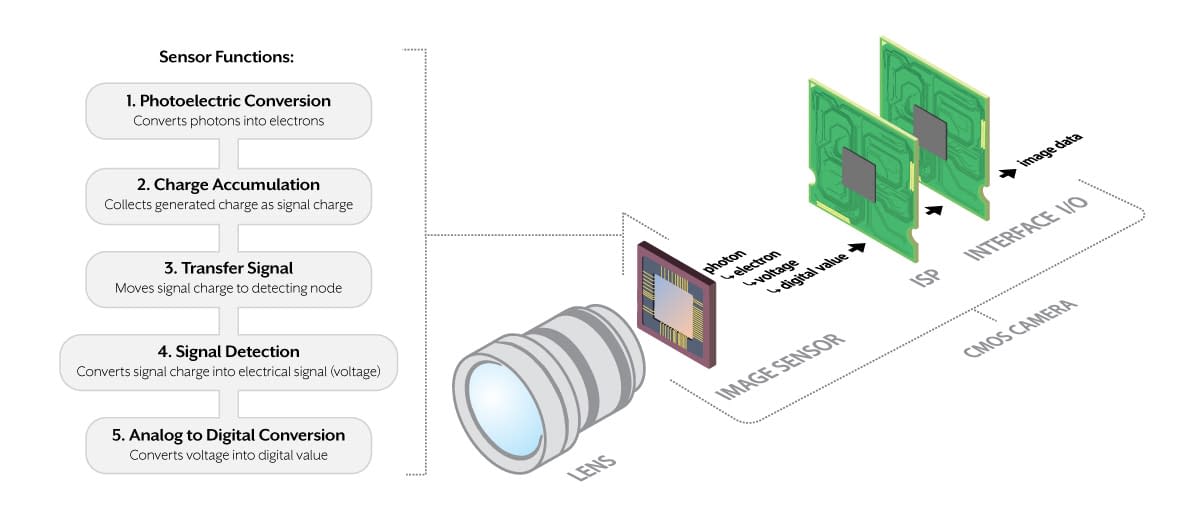

Sensorfunktionen in der Kamera

Im Kamerasystem trifft Licht, gebündelt durch ein Objektiv oder andere Optiken, auf den Bildsensor. Je nach Sensortyp (CCD oder CMOS) wird die Information als Spannung oder digital weitergegeben. CMOS-Sensoren wandeln Photonen in Elektronen, dann in eine Spannung und schließlich per integriertem Analog-/Digital-Wandler in digitale Werte um.

Oben: typischer Aufbau einer CMOS-Kamera

Die Anordnung und Auswahl der Komponenten variiert je nach Hersteller. Ziel ist stets, Licht in ein digitales Signal umzuwandeln, das ausgewertet werden kann, um Aktionen auszulösen. Consumer-Kameras enthalten zusätzliche Elemente für Speicherung, Anzeige und Bedienung, die industrielle Kameras nicht benötigen.

Unterschiede zwischen CCD und CMOS

CCD-Sensoren (Charge-Coupled Device) starten und beenden die Belichtung aller Pixel gleichzeitig, also mit Global Shutter. Die Ladung wird in ein horizontales Schieberegister und dann zum Verstärker übertragen. Hinweis: Sony hat 2015 das Auslaufen der CCD-Fertigung angekündigt und unterstützt CCDs nur noch bis 2026.

Merkmale von CCDs:

Global Shutter. Niedriges Rauschen. Hoher Dynamikumfang. Mittlere Bildraten. Anfällig für Smearing.

Früher konnten CMOS-Sensoren (Complementary Metal-Oxide-Semiconductor) nur zeilenweise belichten, bekannt als Rolling Shutter. Heute gibt es viele CMOS-Sensoren mit Global Shutter. Spaltenweise integrierte A/D-Wandler ermöglichen höhere Bildraten als bei CCDs. Moderne CMOS-Sensoren haben sich so weit entwickelt, dass sie CCDs bei Bildqualität, Geschwindigkeit und Kosten-/Nutzen oft erreichen oder übertreffen.

Merkmale moderner CMOS-Sensoren:

Merkmale moderner CMOS-Sensoren:

Modelle mit Global Shutter oder Rolling Shutter. Sehr geringes Rauschen. Hoher bis sehr hoher Dynamikumfang. Sehr hohe Bildraten. Kein Smearing.

Monochrom- und Farbsensoren

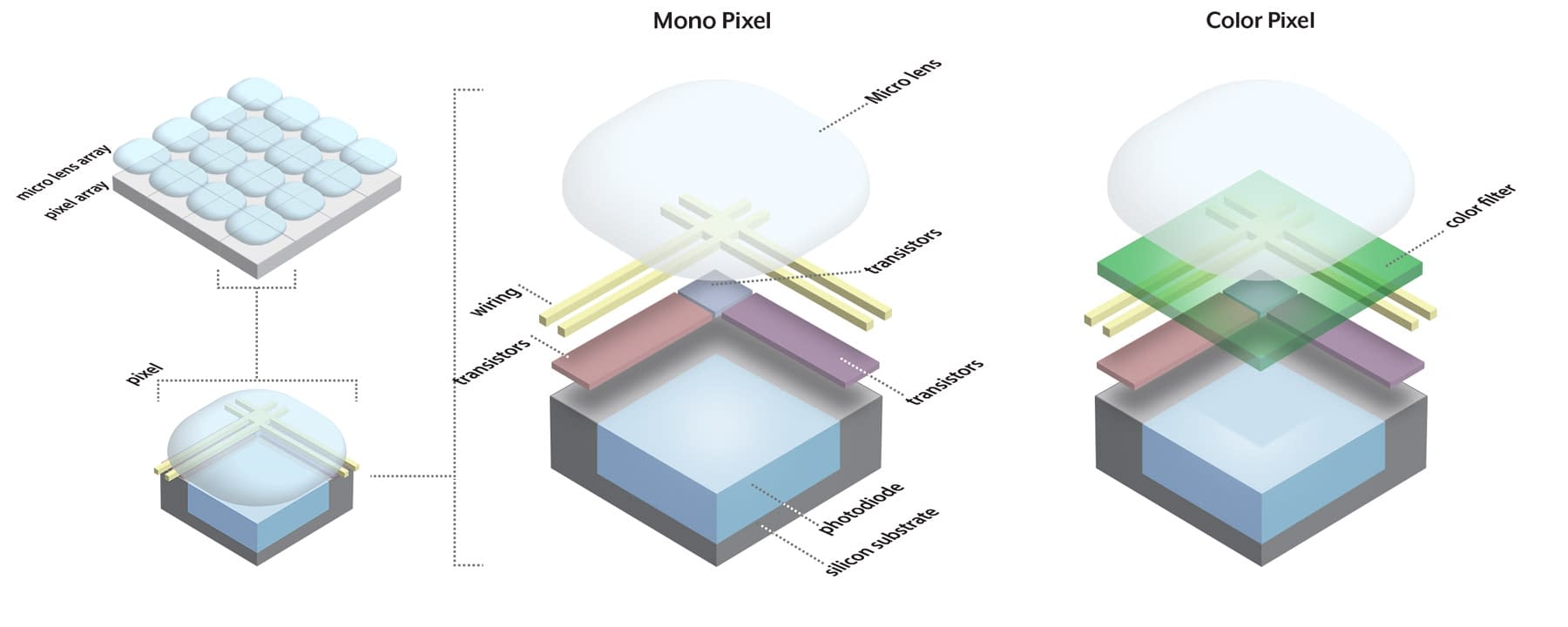

Für Sensoren im sichtbaren Spektrum gibt es zwei Hauptvarianten: Farbe und monochrom. Farbsensoren besitzen unter der Mikrolinse eine zusätzliche Schicht, das Farbfilter, das unerwünschte Wellenlängen absorbiert. So reagiert jedes Pixel auf eine definierte Farbe. Monochrome Sensoren verwenden kein Farbfilter und sind für alle sichtbaren Wellenlängen empfindlich.

Links: monochrome Pixelmatrix. Rechts: Farbmatrix mit Bayer-Pattern

</blockquote]

Im Beispiel rechts kommt ein Bayer-Pattern zum Einsatz mit 50 % Grün sowie je 25 % Rot und Blau. Neben dem Bayer-Filter existieren weitere Anordnungen mit anderer Verteilung und Musterung.

Hinweis

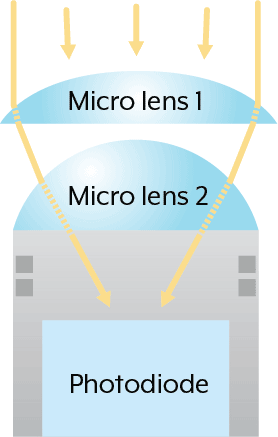

Bei einigen Sensoren, insbesondere mit sehr kleinen Pixeln, unterstützen zusätzliche Mikrolinsen die effiziente Lichtsammlung in der Photodiode.

Sensorformat

Bildsensoren werden in verschiedenen Formaten angeboten. Auflösung und Pixelgröße bestimmen die Chipgröße. Größere Sensoren bieten bei gleichem Format entweder mehr Auflösung oder größere Pixel. Das Sensorformat ist wichtig für die Objektivwahl. Objektive sind für bestimmte Formate und Auflösungen ausgelegt. Das Format bezieht sich nur auf die aktive Chipfläche, nicht auf das gesamte Gehäuse.

Oben, Sensorformate von links nach rechts: 1/6″, 1/3″, 2/3″, 1″

</blockquote]

Das Beispiel zeigt einen CMOS-Sensor mit Formatangabe 2/3″. Die reale Diagonale des Dies beträgt jedoch nur 0,43″ (11 mm). Heutige Zollangaben entsprechen nicht der tatsächlichen Chipdiagonale. Die Bezeichnungen gehen auf Bildaufnahmeröhren zurück, bei denen sich das Maß auf den Außendurchmesser der Röhre bezog. Die folgende Tabelle enthält gängige Formate mit den realen Diagonalen in Millimetern.</p]

Hinweis

Eine historische Videokameraröhre. Deren Durchmesser bildet die Grundlage für die heutigen Sensorformat-Bezeichnungen.</p]

Sensorformat vs. reale Diagonale

| Image Sensor Format (Type) | 1" | 2/3" | 1/1.8" | 1/3" |

| 16 mm | 11 mm | 8.9 mm | ~6 mm |

Pixelgröße des Sensors

Die Pixelgröße wird in Mikrometern (µm) angegeben und umfasst sowohl die Photodiode als auch die umliegende Elektronik. Ein CMOS-Pixel besteht typischerweise aus Photodiode, Verstärker, Reset-Gate, Transfer-Gate und Floating-Diffusion. Teile der Schaltung können sich Pixel teilen. Die folgende Grafik zeigt ein vereinfachtes Layout eines monochromen und eines Farb-Pixels.

Oben: vereinfachtes Layout eines CMOS-Mono- und Farb-Pixels

</blockquote]

Größere Pixel sind in der Regel lichtempfindlicher, da mehr Fläche für die Photodiode zur Verfügung steht. Steigt bei gleichem Sensorformat die Auflösung, müssen die Pixel kleiner werden. Das kann die Empfindlichkeit verringern. Verbesserte Pixelstrukturen, Rauschreduzierung und Bildverarbeitung kompensieren dies zunehmend. Für eine fundierte Bewertung sind die spektrale Empfindlichkeit (Quantum Efficiency) und weitere Messwerte maßgeblich.

Spektrale Empfindlichkeit von Mono und Farbe

Aufgrund konstruktiver Unterschiede zwischen monochromen und farbigen Sensoren sowie unterschiedlicher Herstellertechnologien reagieren Sensoren verschieden stark auf Licht. Ein präziseres Bild liefert das Spektraldiagramm, auch Quantum-Efficiency-Kurve genannt.

Die beiden Diagramme zeigen denselben Sensortyp als Mono und als Farbe. Die X-Achse ist die Wellenlänge in Nanometern, die Y-Achse die Quantum Efficiency in Prozent. Die meisten Farbkameras verwenden IR-Sperrfilter, um nahes Infrarot zu blockieren. Das reduziert IR-Rauschen und Farbübersprechen und entspricht eher der menschlichen Farbwahrnehmung. In manchen Anwendungen ist Bildaufnahme ohne IR-Sperrfilter sinnvoll. Ein Farbsensor ist dennoch nie so empfindlich wie die monochrome Variante.

Oben: zwei Beispielkurven derselben Sensorfamilie. Links Mono, rechts Farbe ohne IR-Sperrfilter

</blockquote]

Je höher die Quantum Efficiency, desto besser nutzt der Sensor das Licht. Die gezeigten Kurven sind Teil der Leistungswerte nach EMVA 1288. Der Standard definiert Mess- und Darstellungsregeln, damit Modelle herstellerübergreifend vergleichbar sind. Besuchen Sie die EMVA-1288-Seite für weitere Informationen.

Global Shutter versus Rolling Shutter

Die Verschlussart ist ein zentrales Sensormerkmal. Die beiden Haupttypen sind Global Shutter und Rolling Shutter. Sie unterscheiden sich in Ablauf und Bildwirkung, insbesondere bei Bewegung von Objekt oder Kamera. Im Folgenden die Funktionsweise und Auswirkungen.

Global-Shutter-Timing

Beim Global Shutter starten und enden alle Pixel gleichzeitig. Das Auslesen erfolgt dennoch zeilenweise. Das Ergebnis sind verzerrungsfreie Bilder ohne Wobble oder Skew. Global-Shutter-Sensoren sind für sehr schnelle Bewegungen unverzichtbar.

Rolling-Shutter-Timing

Beim Rolling Shutter verschieben sich Reset und Auslesen zeilenweise. Das kann bei Bewegung zeilenabhängige Verzerrungen erzeugen. Rolling-Shutter-Sensoren bieten eine sehr hohe Empfindlichkeit und sind ideal für statische oder langsam bewegte Szenen.

Fazit

Wer neu in der industriellen Bildverarbeitung ist, findet hier einen kompakten Einstieg in Sensorbegriffe und Klassifizierungen. Mit diesem Verständnis wählen Sie die passende Kamera gezielter aus. Spezifikationen wie Pixelgröße und Sensorformat beeinflussen auch die Objektivwahl. Neue Sensortechnologien lassen sich so besser einordnen. Wenn Sie Ihre Anforderungen besprechen möchten, kontaktieren Sie unser LUCID Vertriebsteam.