Das hohe Tempo der Innovation

Da Bildverarbeitungssysteme immer höhere Auflösungen und Bildraten erreichen, stößt das wachsende Datenvolumen an die Grenzen klassischer Netzwerkkonfigurationen und überschreitet diese teils bereits. Mit der zunehmenden Verbreitung von 10GigE- und 25GigE-Kameras, die enorme Datenraten und komplexe Bildverarbeitungsprozesse erfordern, können Integratoren auf Paketverluste stoßen. Das führt zu höherer CPU-Last und schwankender Latenz. Solche Herausforderungen erfordern häufig gezielte Optimierungen oder sogar proprietäre Lösungen.

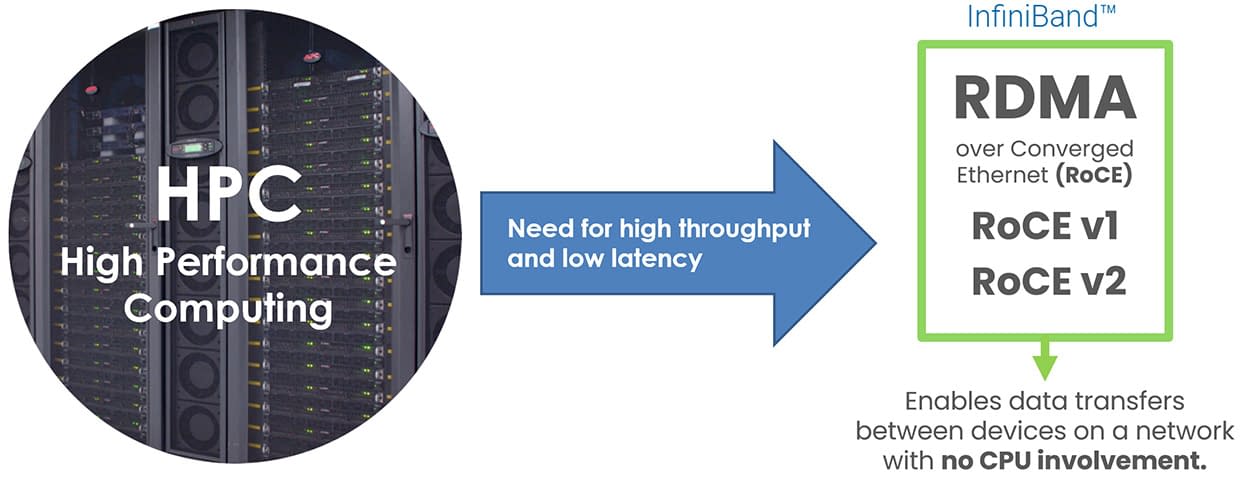

Mit GigE Vision 3.0 und der Unterstützung von RDMA über den RoCE v2 Standard steht nun jedoch ein leistungsfähiges Transportprotokoll zur Verfügung, das sich in Rechenzentren und HPC-Umgebungen bewährt hat. Dieser Artikel zeigt, wie GigE Vision und RoCE v2 kombiniert werden, um effiziente, skalierbare und zukunftssichere Netzwerke für die industrielle Bildverarbeitung bereitzustellen.

Inhaltsverzeichnis

GigE Vision und RoCE v2: Zwei Standards auf getrennten Wegen

Der GigE Vision Standard wurde 2006 eingeführt, um die Übertragung von Bilddaten über Ethernet in der industriellen Bildverarbeitung zu vereinheitlichen. Er ist ein gemeinschaftlicher Standard, getragen von Ingenieuren aus Kamera- und Softwareunternehmen, die ihre Zeit ehrenamtlich investieren, um ihn kontinuierlich weiterzuentwickeln. Neue Anforderungen werden erst nach gründlicher Analyse, Diskussion und Abstimmung in den Standard aufgenommen. Die Konformität wird durch umfassende Tests sichergestellt, einschließlich einer Validierungssuite für Kameras mit Hunderten definierter Anforderungen. Nur Produkte, die diese Tests bestehen, gelten als GigE Vision konform und garantieren damit herstellerübergreifende Interoperabilität sowie zuverlässiges Verhalten im Produktionseinsatz. Der Standard basiert auf UDP und schafft damit einen gemeinsamen Rahmen für Kameras, Software und Netzwerktechnik.

Im Laufe der Jahre wurde GigE Vision mehrfach erweitert: Paketwiederholung und Chunk-Daten (1.1, 2008), Link Aggregation und 10 Gigabit über IEEE 802.3ba sowie Kompression und Steuerung nicht-streamender Geräte (2.0, 2012), Verbesserungen bei Puffer- und Ereignisbehandlung sowie Unterstützung komplexerer 3D-Strukturen (2.1, 2018) und GenDC-Streaming mit Multi-Event-Daten (2.2, 2022).

Parallel dazu stand die Rechenzentrums- und HPC-Industrie vor der Frage, wie sich große Datenmengen mit minimaler Latenz und geringer CPU-Belastung zwischen Servern übertragen lassen. Dies führte zur Entwicklung von RDMA-Technologien und zur Einführung von RoCE (RDMA over Converged Ethernet). Entwickelt von der InfiniBand Trade Association, überträgt RoCE die RDMA-Vorteile von InfiniBand auf Standard-Ethernet. RoCE v1 (2010) arbeitete auf Layer 2 und war auf lokale Segmente beschränkt. RoCE v2 (2014) wurde um UDP/IP-Kapselung erweitert und ist dadurch routbar und skalierbar. In den letzten zehn Jahren setzte sich RoCE v2 trotz konkurrierender Technologien in Cloud, Storage und Echtzeitanalytik breit durch.

1983

1993

1998

2002

Released

2010

Spec v1 Released

2000

2010

Linux Compatibility

2004

2018

Released

2014

2.5 / 5 Gbps

(NBase-T)

2016

400 Gbps

2017

2011

2012

2023 and Beyond...

Warum jetzt: RDMA und GigE Vision wachsen zusammen

Die Idee, RDMA für Ethernet-basierte Industriekameras einzusetzen, wurde bereits 2016 vom GigE Vision Komitee geprüft. Ein Vorschlag von 2017 definierte einen neuen GVSP-Payload-Typ für RDMA. Technisch überzeugend, aber das Ökosystem war noch nicht bereit. Neben RoCE v2 gab es konkurrierende Protokolle wie iWarp oder Intels Omni-Path. Zudem waren RoCE v2 NICs teuer, nur von einem Hersteller verfügbar und erforderten hohen Integrationsaufwand.

Zur gleichen Zeit deckten 1GigE-Kameras die meisten Anwendungen zuverlässig ab. Für höhere Bandbreiten gab es Alternativen wie USB 3.0, Camera Link oder CoaXPress. 10GigE wurde zwar eingesetzt, meist jedoch mit optimiertem UDP-Streaming und leistungsstarken PCs. Viele Hersteller wollten den Aufwand für ein vollständiges RDMA-Ökosystem nicht tragen. Ohne breite Unterstützung von Herstellern oder Endanwendern wurde RDMA daher zunächst zurückgestellt.

Mit steigender Nachfrage nach Multi-10GigE-Systemen wurde RDMA erneut interessant. Kunden wollten die industriellen Vorteile von Ethernet wie Isolation, Kabellängen, PoE, PTP und Action Commands mit hoher Bandbreite kombinieren. Doch bei Multi-10GigE stiegen CPU-Last und Paketverluste stark an. Damit wurde klar: RDMA musste für GigE Vision neu bewertet werden.

Parallel reifte RoCE v2 weiter. Mit Broadcom BCM57414-Chips wurden NICs erschwinglich, Betriebssysteme wie Windows und Linux boten stabile Unterstützung. RoCE v2 setzte sich gegenüber iWarp und anderen durch. Daher beschloss das GigE Vision Komitee, RoCE v2 RDMA als optionales Transportprotokoll in den Standard aufzunehmen. UDP bleibt erhalten, doch RDMA bietet eine leistungsfähige Alternative ohne CPU-Overhead.

Wie RoCE v2 RDMA die CPU-Last in Bildverarbeitungssystemen reduziert

In UDP-basierten Systemen übernimmt die CPU Paketassemblierung, Validierung, Wiederholung und Kopieren in die Anwendungs-Puffer. RDMA geht effizienter vor: Mit RoCE v2 werden Bilddaten direkt aus dem Kamerapuffer in den PC-Speicher übertragen, ohne Kernel oder CPU zu belasten. Der Speicher wird in der RDMA-NIC registriert und bleibt im physischen RAM fixiert. Die NIC steuert den Datenstrom inklusive Flow-Control und Paketwiederholung.

Jede RDMA-Verbindung nutzt ein Queue-Pair aus Send- und Receive-Queue sowie eine Completion-Queue für den Übertragungsstatus. Diese werden von der NIC-Hardware verwaltet. Da Transfers komplett in Kamera- und NIC-Hardware laufen, bleibt die CPU unbeteiligt. Dieses Zero-Copy-Verfahren senkt Overheads, verbessert die Deterministik und entlastet die CPU. Ressourcen stehen damit für Bildverarbeitung, GUI oder Steuerlogik bereit.

Entwickler-APIs und Softwareunterstützung für RDMA

Für die Implementierung nutzen Entwickler Low-Level-APIs, die sogenannten Verbs. Unter Linux bietet libibverbs den Zugriff, unter Windows Microsofts Network Direct SPI. Diese Schnittstellen ermöglichen Herstellern den Zugriff auf RDMA-Funktionen für High-Performance-Streaming. So lässt sich RDMA etwa in LUCIDs Arena SDK, ArenaView-GUI und anderen GigE Vision konformen Tools nutzen.

Die Verbs bilden die Low-Level-Bausteine für RDMA-Anwendungen.

Die APIs ermöglichen Speicherregistrierung, Queue-Verwaltung und Zero-Copy-Datenbewegung. Der GigE Vision 3.0 Standard legt fest, wie RDMA-Ströme eingerichtet, betrieben und beendet werden, welche Register nötig sind und welche Paketformate genutzt werden. Dadurch bleibt die Kameraleistung konsistent und Implementierungen interoperabel.

Für Integratoren bedeutet dies mehr Flexibilität. Sie sind nicht auf einen Hersteller angewiesen, sondern können mit standardisierten Komponenten arbeiten. Da RoCE v2 IP-routbar ist, lässt es sich nahtlos mit bestehender Ethernet-Infrastruktur kombinieren.

LUCID Vision Labs hat RDMA bereits in die Atlas10- und Triton10-Kameras integriert. Offizielle GigE Vision 3.0 Unterstützung folgt nach der Standard-Ratifizierung. Zusammen mit RDMA-NICs wie LUCIDs 2- und 4-Port-PoE-Karten lassen sich Bilddaten direkt in den Host-Speicher übertragen. Ideal für Anwendungen mit Echtzeit-Inferenz oder hohen Bildraten wie Robotik oder Inline-Inspektion. Durch die Entlastung der CPU wird auch bei mehreren Kameras ein gleichbleibend hoher Durchsatz mit niedriger Latenz erreicht.

RDMA für GigE Vision: für die Zukunft entwickelt, heute einsatzbereit

Die Integration von RDMA über RoCE v2 in GigE Vision 3.0 ist ein wichtiger Schritt für leistungsstarke Bildverarbeitungssysteme. Der Wert liegt nicht nur in höherer Performance, sondern auch in der Standardisierung. RoCE v2 ist etabliert in Rechenzentren und Cloud, GigE Vision 3.0 definiert die Regeln für Interoperabilität. Anwender profitieren von reduzierten Integrationskosten, einfacher Skalierbarkeit und langfristiger Unterstützung. Damit sind Systeme nicht nur schneller, sondern auch zukunftssicher.