Anders erfassen

Inhaltsverzeichnis

Tuning-Funktionen wie Bias Event Thresholds, Bias Filter Cutoff, Bias Refractory Period und Region of Interest (ROI) ermöglichen eine präzise Steuerung von Sensorempfindlichkeit und Reaktion. Zusätzlich reduzieren Filter wie der Anti-Flicker Filter, der Event Burst Filter und die Event Rate Control (ERC) unerwünschte Events. Durch die Anpassung dieser Funktionen lässt sich die Empfindlichkeit feinabstimmen und Redundanz minimieren, sodass nur die relevantesten Daten ausgegeben werden.

Bevor wir diese Funktionen im Detail betrachten, geben wir zunächst einen Überblick, wie konventionelle Area-Scan-Kameras mit der Event-basierten Triton2 EVS verglichen werden können und wie Event-basierte Sensoren grundsätzlich arbeiten.

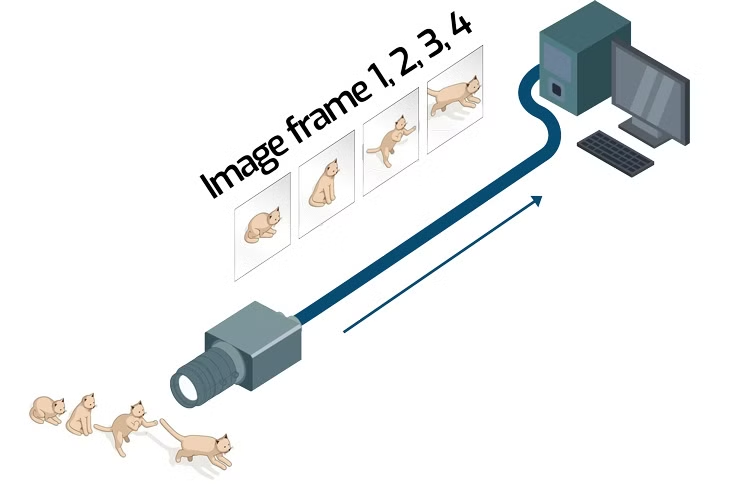

Area-Scan-Kamera

Alle Pixel des Sensors erfassen die Lichtluminanz entweder gleichzeitig (Global Shutter) oder zeilenweise nacheinander (Rolling Shutter). Die Kamera verarbeitet diese Daten anschließend zu Bildframes.

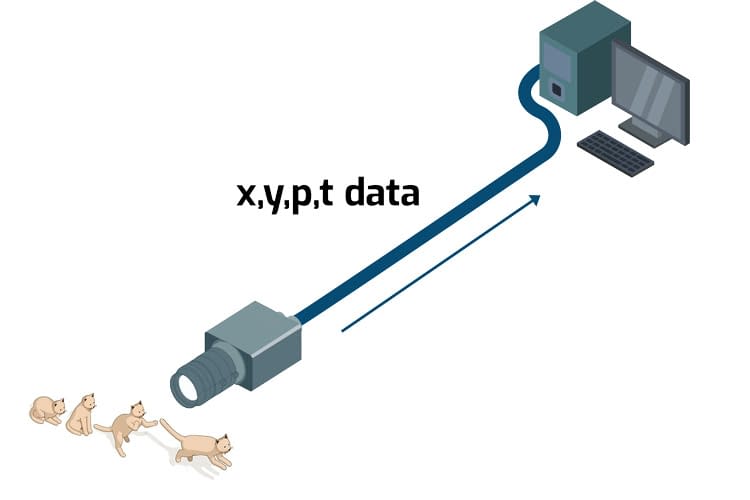

Event-basierte Kamera

Jedes Pixel arbeitet unabhängig, erkennt Änderungen der Luminanz (Helligkeit) und gibt die Koordinaten (x, y), die Polarität (p) und den Zeitstempel (t) aus, sobald die Änderungen einen voreingestellten Schwellwert überschreiten. Ein Shutter- oder Frame-Konzept gibt es bei Event-basierten Sensoren nicht; nur Pixel mit Änderungen senden Daten, was das gesamte Datenaufkommen reduziert.

Funktionsweise von Event-Pixel und Sensor

Im Event-basierten Bildsensor IMX636/637 überwacht jedes Pixel im Array eigenständig die Luminanz des einfallenden Lichts. To do so, the pixel first converts das Licht zunächst in eine Spannung. Diese Spannung durchläuft einen Low-Pass- und High-Pass-Filter, die die Frequenz bzw. Zeitauflösung von Kontraständerungen steuern. Anschließend wird die Spannung mit einer Referenzspannung verglichen und das Delta gebildet. Dieses Delta gelangt in eine Threshold-Prüfung, die festlegt, welche Kontraständerung passieren darf. Überschreitet die Luminanz den positiven Schwellwert, wird ein positives Event (dunkel zu hell) erzeugt; unterschreitet sie den negativen Schwellwert, entsteht ein negatives Event (hell zu dunkel). Dieses Merkmal heißt Polarität des Events. Nach einem Event setzt das Pixel die Referenzspannung auf das neue Luminanzniveau zurück. Die folgende Animation zeigt die Hauptstufen der Pixelverarbeitung sowie die Positionen von Filtern und Thresholds.

Hinweis

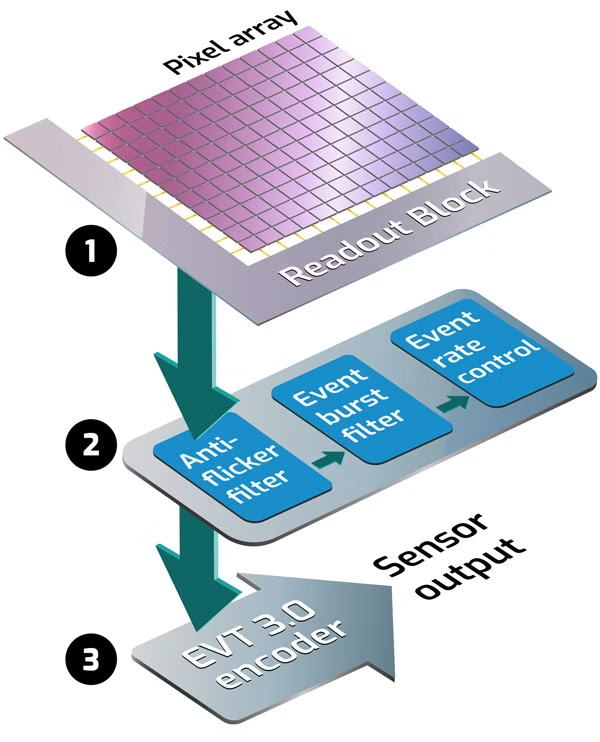

Nachdem ein Pixel im IMX636/637 einfallendes Licht in eine Spannung umgewandelt hat, gelangt das Signal in den Readout-Block:

2. Der Signalverarbeitungs-Block filtert Events (optional).

3. Event-Daten werden im EVT-3.0-Format kodiert und ausgegeben.

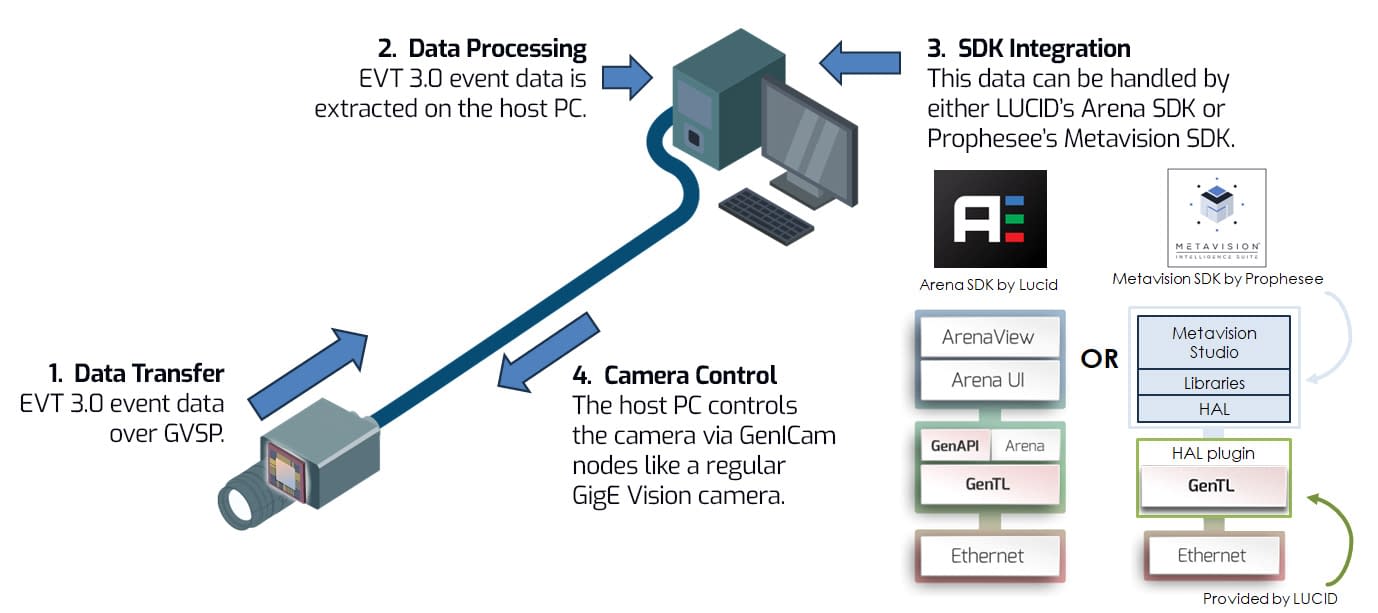

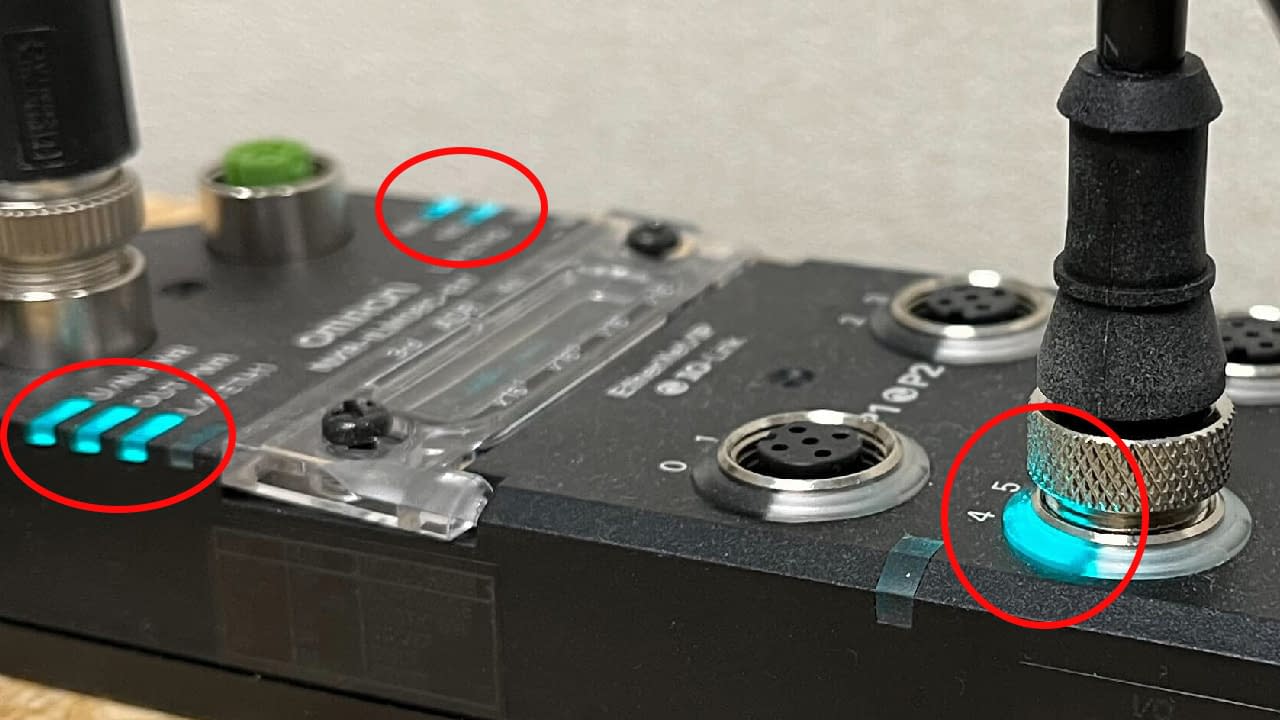

So arbeitet Triton2 EVS mit PC-Software

Nach der Verarbeitung der Event-Signale durch Threshold-Filter durchlaufen die Events zusätzliche, optionale Filter: Anti-Flicker Filter, Event Burst Filter und Event Rate Control. Diese Filter werden später im Artikel ausführlich beschrieben. Anschließend kodiert die Triton2 EVS die Event-Daten in EVT 3.0*, ein komprimiertes 16-Bit-Format von Prophesee. Die Übertragung erfolgt über das GigE Vision Streaming Protocol (GVSP), einen Standard zur Datenübertragung über Ethernet für Machine-Vision-Kameras.

Auf dem Host-PC werden die Daten entpackt und können mit dem Arena Software Development Kit (SDK) von LUCID verarbeitet werden. Das Arena SDK ermöglicht verschiedene Wege: XYPT-Daten dekodieren und weiterverarbeiten, CD-Frames erzeugen und in ArenaView visualisieren oder die Daten im ursprünglichen EVT-3.0-Format belassen. Alternativ kann das Metavision SDK von Prophesee eingesetzt werden. Bei Verwendung des Metavision SDK übersetzt ein HAL-Plugin für die Triton2 EVS die Steuerkommandos in ein von der Kamera verstandenes Format. Nutzer des Metavision SDK müssen sich somit nicht um Details der Kamerasteuerung kümmern.

Für die Kamerasteuerung und Sensorkontrolle werden GenICam-Nodes verwendet. GenICam stellt eine generische Programmierschnittstelle für Machine-Vision-Kameras bereit und ermöglicht eine konsistente Bedienung ähnlich wie bei einer regulären GigE-Vision-Kamera.

Event-Daten visualisieren: CD-Frames

Wie oben erwähnt, kann das Arena SDK EVT-3.0-Daten in einzelne Bildframes umwandeln, sogenannte CD-Frames (Contrast Detector Frames), die in der ArenaView-GUI angezeigt werden. CD-Frames tragen positive und negative Events in einem XY-Koordinatensystem innerhalb eines definierten Frame-Zeitraums auf. Dies ist die einfachste und schnellste Visualisierung, hat jedoch Grenzen: Mehrfachaktivierungen desselben Pixels innerhalb eines Frames sowie das Timing innerhalb des Frames werden nicht dargestellt. Sowohl ArenaView (Teil des Arena SDK) als auch Metavision Studio (Teil des Metavision SDK) können Event-Daten als CD-Frames visualisieren.

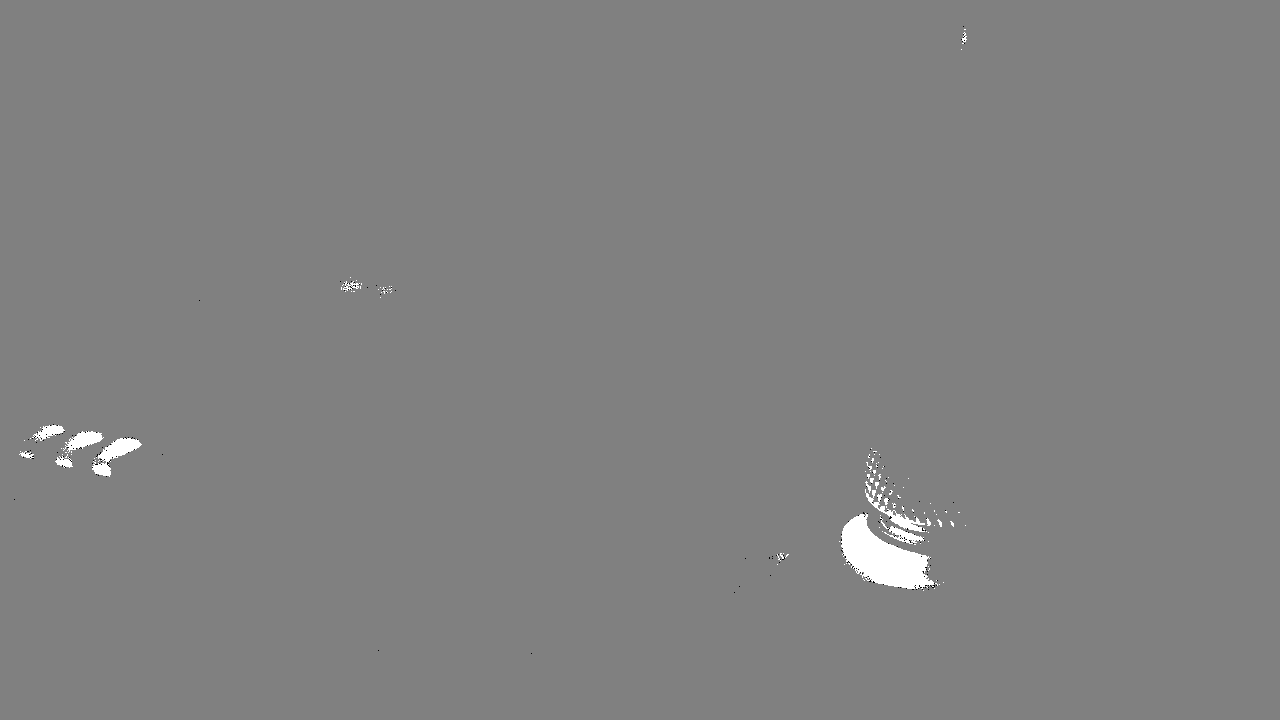

In diesem Beispielvideo werden in ArenaView CD-Frames angezeigt. Es werden nur wenige Events detektiert, da das Zielobjekt stillsteht und nahezu keine Kontraständerungen auftreten.

Hier sieht man viele Events, bedingt durch a) die Bewegung der Person und b) den starken Kontrast des schwarzen Pullovers zur weißen Wand.

Erzeugte Events (Kontraständerungen) entsprechen entweder einem positiven Event (dunkel zu hell) oder einem negativen Event (hell zu dunkel). Dies ist die Polarität eines Events.

Überblick: Biases und Filter

In den folgenden Abschnitten betrachten wir Biases, Filter und weitere Funktionen der Triton2 EVS, mit denen sich Events gezielt feinjustieren lassen. Die Tabelle fasst zusammen, wie jede Funktion die Ausgabe der Kamera beeinflusst. Ein Klick auf den Bias- bzw. Filternamen springt direkt zum Abschnitt.

| Bias / Filter Name | Description | Bias Decrease / Filter Off | Bias Increase / Filter On |

|---|---|---|---|

| Bias Low Pass Filter Cutoff | Defines how the camera filters out rapid contrast changes. | Removes high-frequency changes. Increases latency. Reduces background rate, noise, and event rate. | Keeps high-frequency changes. Improves pixel latency. Increases the background rate. |

| Bias High Pass Filter Cutoff | Defines how the camera filters out slow changes in contrast. | Preserves low-frequency changes and slow motion. Increases event rate and noise. | Removes low-frequency signals. Removes slow motion. Decreases event rate and noise. |

| Bias Event Threshold Positive | Defines how sensitive each pixel is to positive contrast (dark to light) changes. | Increases background rate. Improves pixel latency. | Decreases sensitivity. Decreases background rate. Reduces event rate. |

| Bias Event Threshold Negative | Defines how sensitive each pixel is to negative contrast (light to dark) changes. | Increases background rate. Improves pixel latency. | Decreases sensitivity. Decreases background rate. Reduces event rate. |

| Bias Refractory Period | Controls the amount of time the pixel sleeps after an event. | Reduces the number of events triggered by a large contrast change. | Improves pixel availability. More events are triggered by a large contrast change |

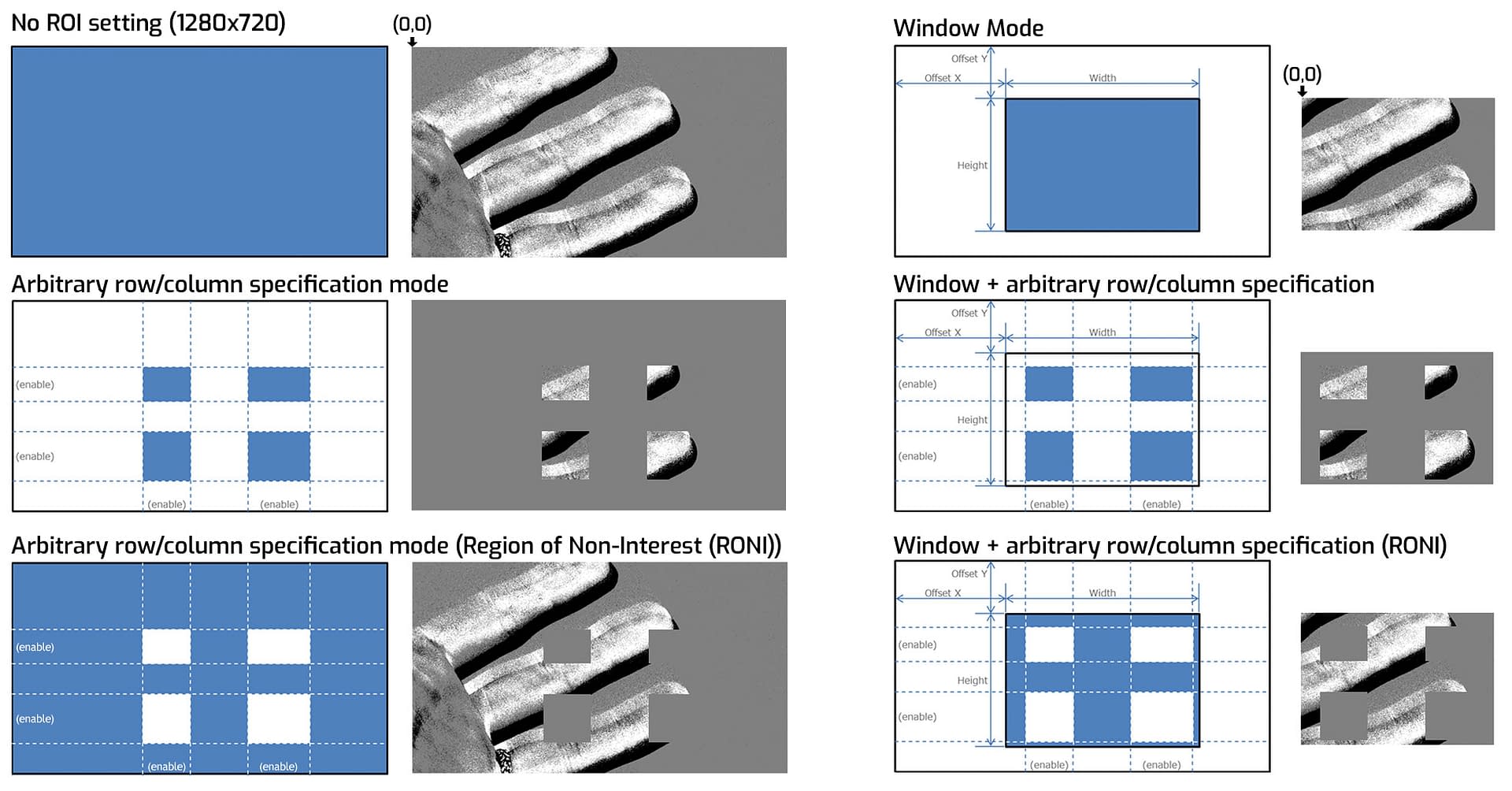

| Region of Interest (ROI) | Isolates width and height regions with X and Y offsets of the senor for sensing. Can also be inverted to mask sections. | The full resolution of the sensor is used to detect event data. | Can be used in Window Mode (one ROI region), Arbitrary Row/Column Specification Mode, or both. This reduces the overall event rate. |

| Anti Flicker Filter | Eliminate flickering in a specified frequency range. (ie from LEDs or fluorescent lights). | Flickering light is captured and increases event rate. | Flickering lights will be removed, reducing event rate. Filter can also be inverted to capture only the flickering light. |

| Event Burst Filter | Removes redundant events from a burst of events with the same polarity. | No events are filtered. | The TRAIL filter only outputs the first event of a burst. The STC filter outputs the second event of a burst or the second event to the end of a burst. |

| Event Rate Control (ERC) | Event rate control (ERC) drops events to keep the output event rate below the target event rate. | The camera processes all detected events. Can lead to data overflow if too many events saturate the data bandwidth connection. | Events are dropped if the rate exceeds the target during each 200 µs period after filtering. |

Bias Low Pass Filter Cutoff

Bias High Pass Filter Cutoff

Zur Anpassung der detektierten Kontrastfrequenzen ist jedes Pixel mit Bias Low Pass Filter Cutoff und Bias High Pass Filter Cutoff ausgestattet.

Der Bias Low Pass Filter Cutoff stellt die Grenzfrequenz des Tiefpassfilters ein und bestimmt, wie schnelle Kontraständerungen gefiltert werden. Ein niedrigerer Wert entfernt Hochfrequenzanteile, erhöht die Latenz und verringert Background-Rate, Rauschen und Event-Rate. Ein höherer Wert lässt Hochfrequenzen durch, verbessert die Pixel-Latenz und erhöht die Background-Rate.

Der Bias High Pass Filter Cutoff stellt die Grenzfrequenz des Hochpassfilters ein und bestimmt, wie langsame Kontraständerungen unterdrückt werden. Ein niedrigerer Wert erhält niederfrequente Änderungen und langsame Bewegungen, was Event-Rate und Rauschen erhöht. Ein höherer Wert entfernt niederfrequente Signale und langsame Bewegungen, wodurch Event-Rate und Rauschen sinken.

Das Absenken des Bias Low Pass Filter Cutoff erhöht Event-Latenz und Varianz; eine Erhöhung hat wenig Einfluss. Das Anheben des Bias High Pass Filter Cutoff reduziert Events durch langsame Kontraständerungen. So lässt sich die Leistung der Kamera je nach Anwendung fein abstimmen, z. B. zur Verbesserung der Erkennungsgenauigkeit oder zur Rauschreduktion.

Bias Low Pass Filter Cutoff – Beispiele (Zum Vergrößern klicken)

Bias High Pass Filter Cutoff – Beispiele (Zum Vergrößern klicken)

Mit steigendem Wert sinkt die Zahl der Events durch langsame Kontraständerungen.

Bias Event Threshold Positive

Bias Event Threshold Negative

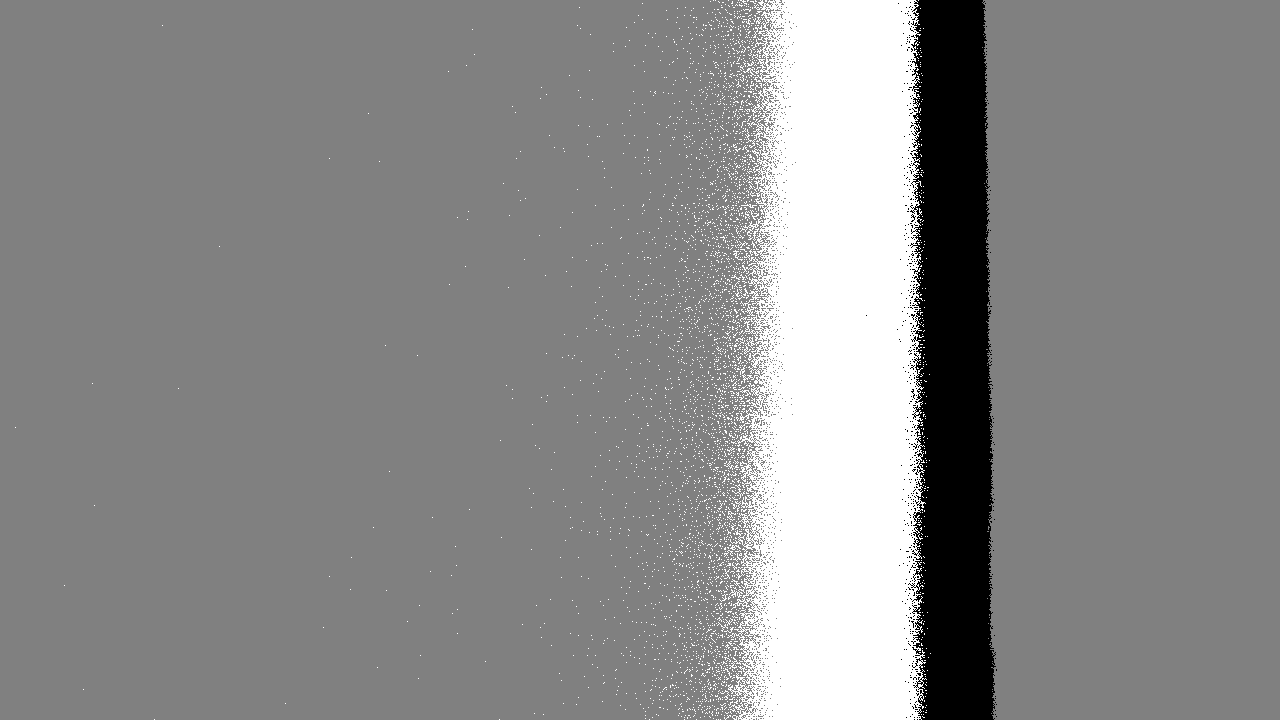

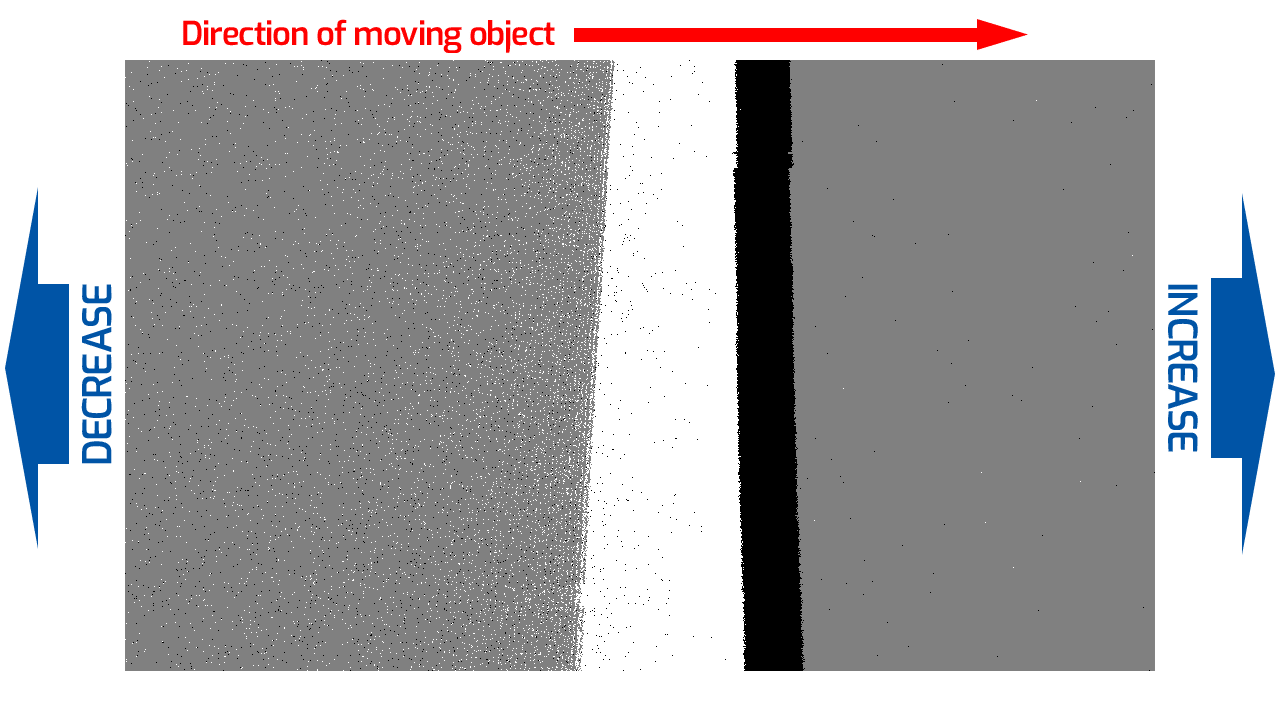

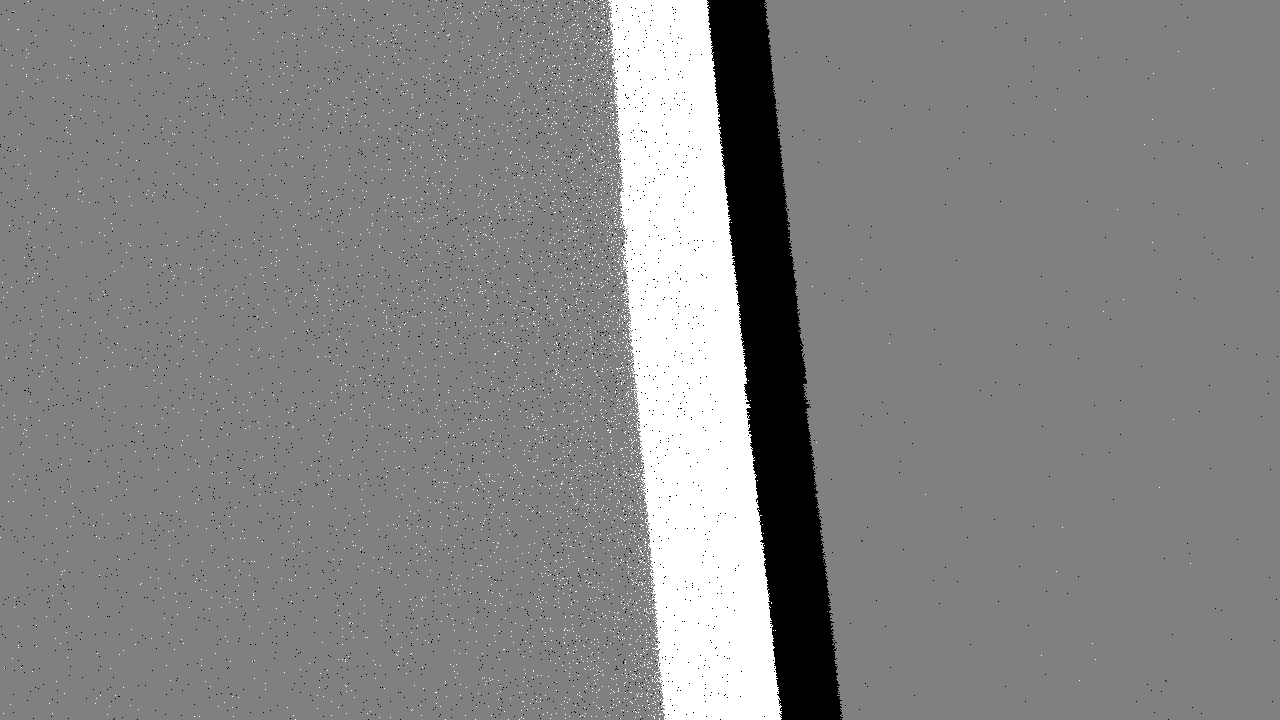

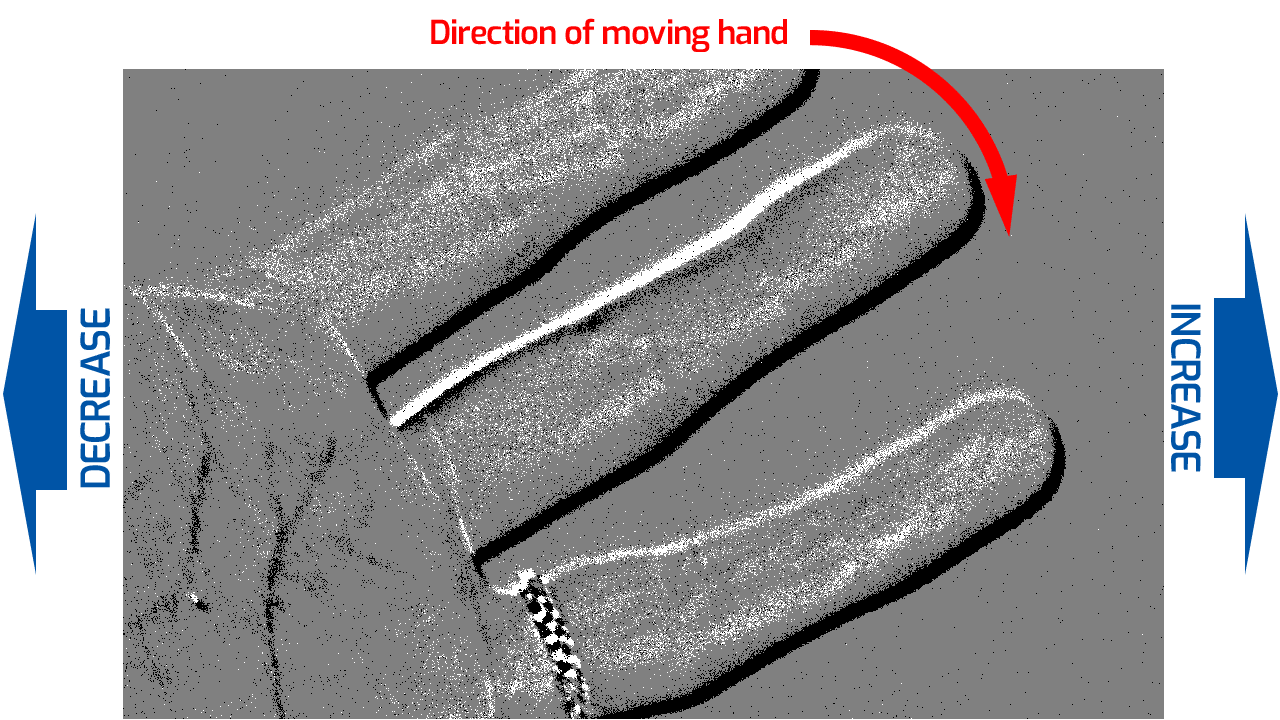

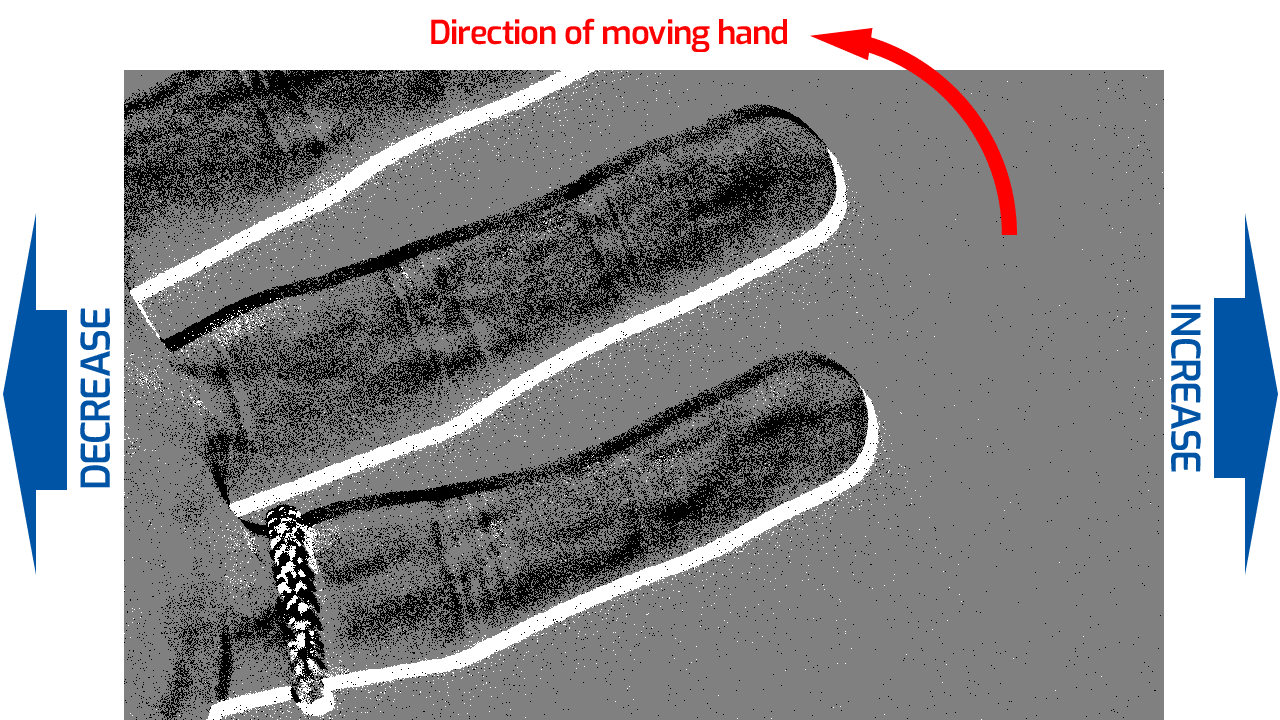

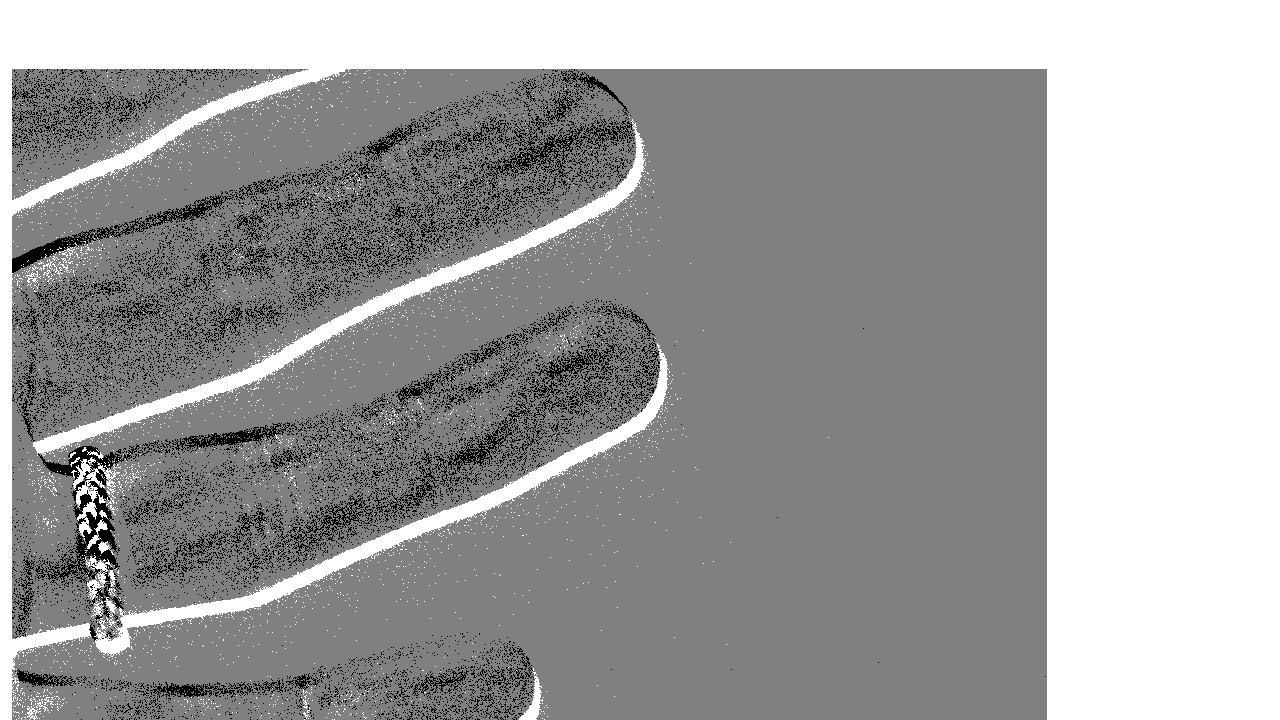

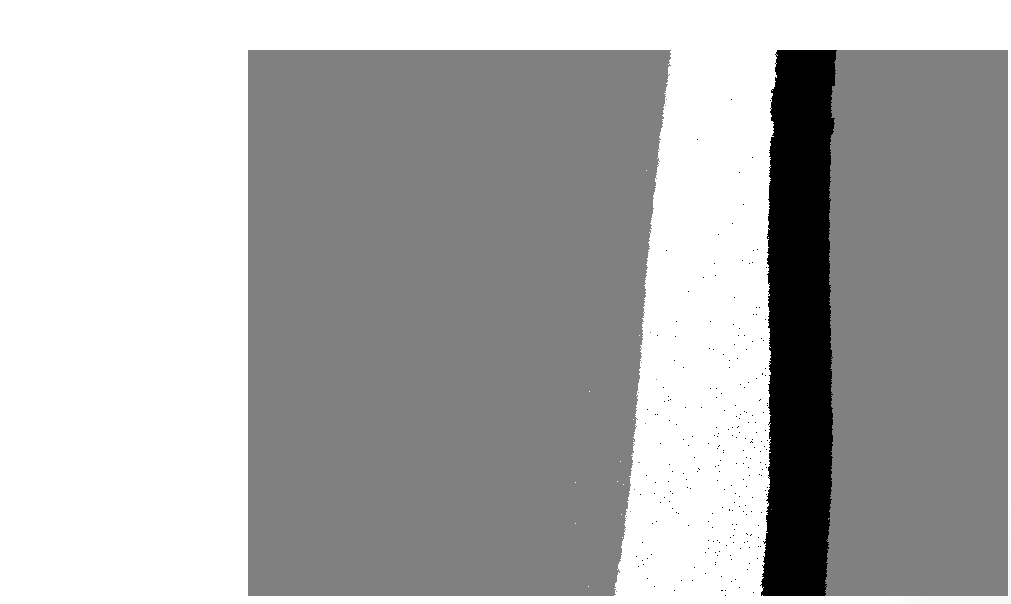

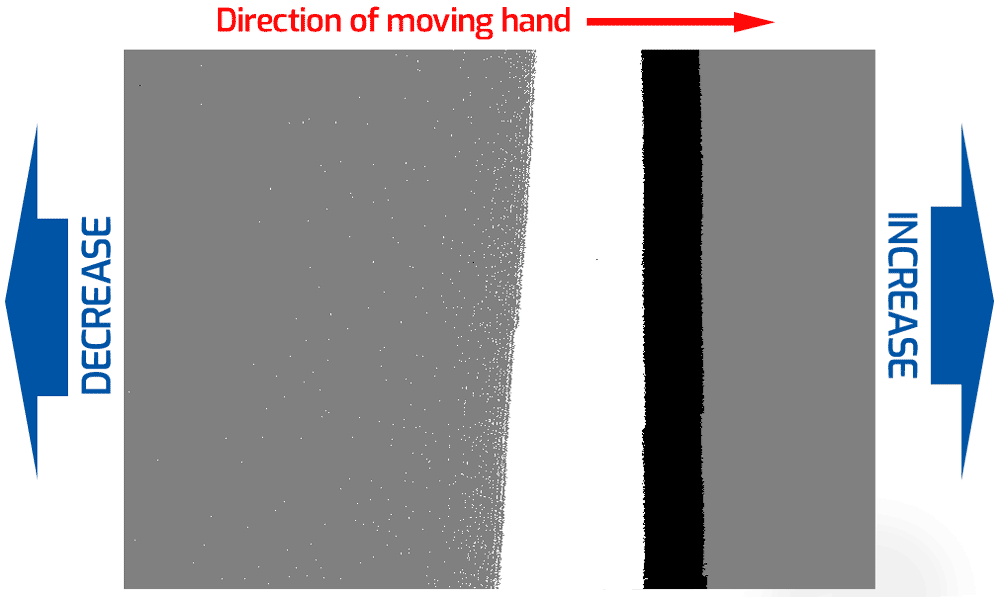

Diese beiden Bias Event Thresholds bestimmen die Empfindlichkeit gegenüber Kontraständerungen und legen fest, welche Intensität eine Änderung haben muss, damit ein Event ausgelöst wird. Es gibt Positive und Negative Thresholds.

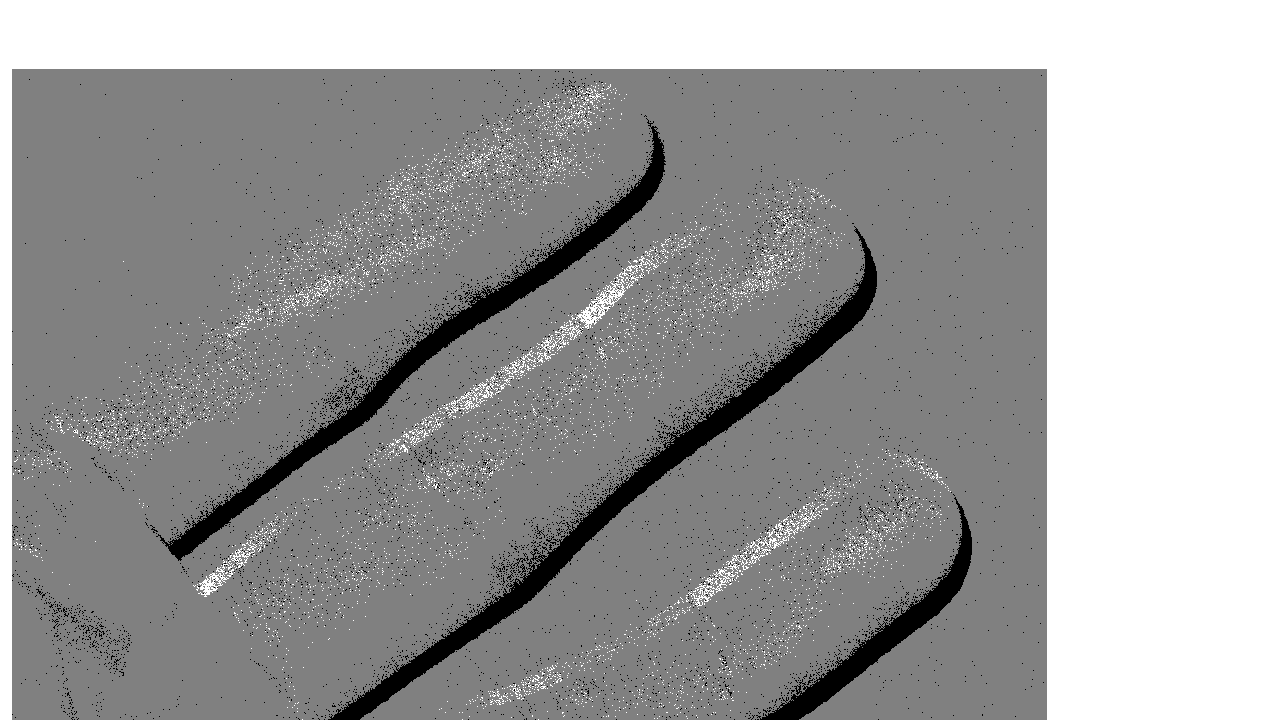

Der Bias Event Threshold Positive steuert die Empfindlichkeit für ON-Events (wie stark die Helligkeit steigen muss, um ein positives Event zu erzeugen), üblicherweise als weiße Pixel dargestellt. Ein niedrigerer Wert erhöht die Zahl positiver Events, es erscheinen mehr weiße Pixel. Ein höherer Wert reduziert die Empfindlichkeit, es werden weniger weiße Pixel angezeigt.

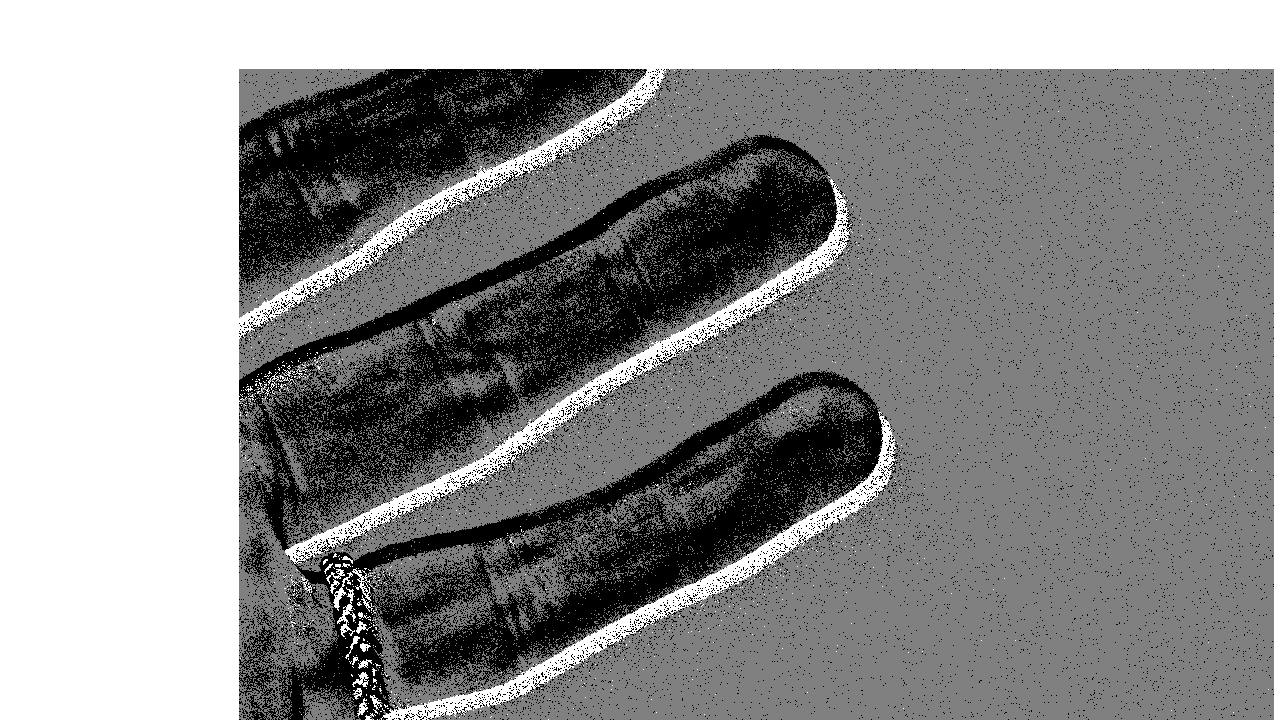

Der Bias Event Threshold Negative steuert die Empfindlichkeit für OFF-Events (wie stark die Helligkeit fallen muss, um ein negatives Event zu erzeugen), üblicherweise als schwarze Pixel dargestellt. Ein niedrigerer Wert erhöht die Zahl negativer Events, es erscheinen mehr schwarze Pixel. Ein höherer Wert reduziert die Empfindlichkeit, es werden weniger schwarze Pixel angezeigt.

Für beide Thresholds gilt: Ein niedrigerer Wert verbessert die Pixel-Latenz, erhöht jedoch die Event-Rate und das Rauschen. Höhere Werte reduzieren die Empfindlichkeit und helfen, die Event-Rate zu senken.

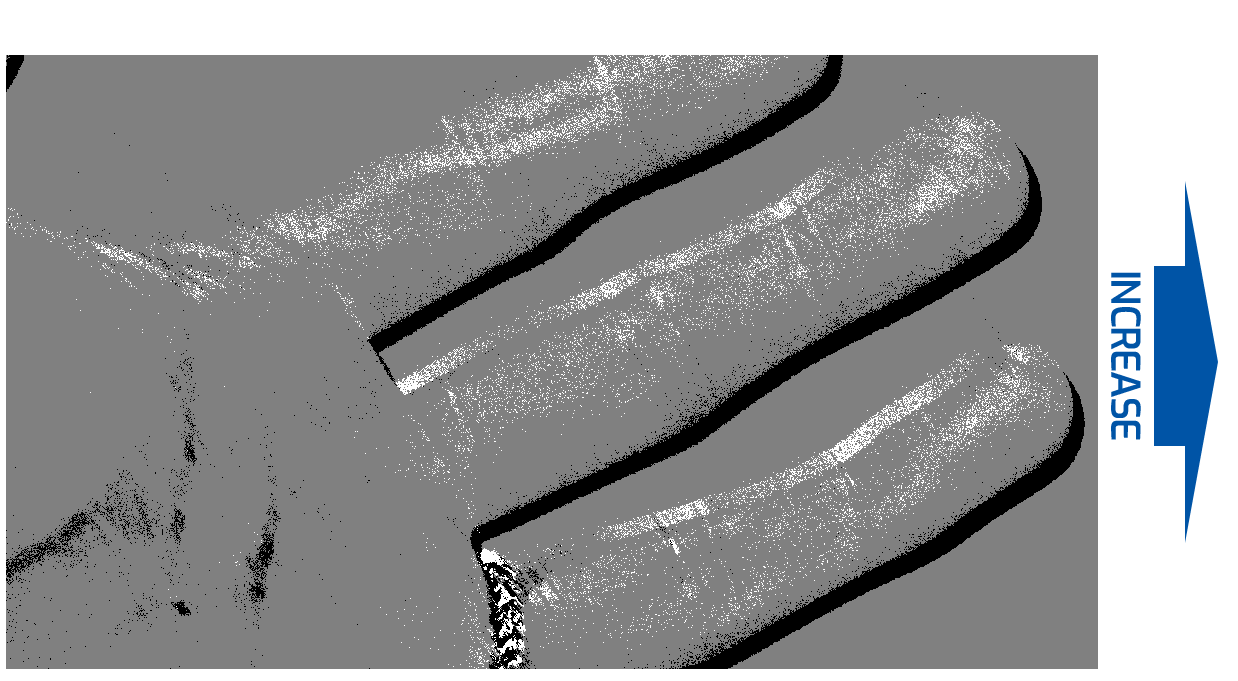

Bias Event Threshold Positive – Beispiele (Zum Vergrößern klicken)

Bias Event Threshold Negative – Beispiele (Zum Vergrößern klicken)

Bias Refractory Period

Die Refractory Period legt fest, wie lange ein Pixel nach einem Event inaktiv bleibt. Diese „Schlafzeit“ verhindert sofortige Reaktionen auf nachfolgende Events und ist besonders in Umgebungen mit schnellen oder großen Kontraständerungen hilfreich. Mit der Refractory Period lässt sich die Zahl der durch starke Änderungen ausgelösten Events steuern. Eine längere Refractory Period reduziert Events, eine kürzere erhöht sie.

Bias Refractory Period – Beispiele (Zum Vergrößern klicken)

Region of Interest (ROI)

Die Triton2 EVS bietet zwei Verfahren zur Spezifikation der Region of Interest (ROI). Erstens lässt sich eine Window-ROI über Parameter wie Width, Height, Offset X und Offset Y definieren, analog zu Area-Scan-Kameras. Damit wird ein Fensterbereich präzise festgelegt. Zweitens können Multi-ROI-Spalten/-Zeilen aktiviert werden (arbitrary row/column specification), sodass einzelne Zeilen und Spalten gezielt ein- oder ausgeschaltet werden. Zudem unterstützt das System das Invertieren der ROI (Region of Non-Interest, RONI) als Maske, um unerwünschte Bereiche auszublenden. So lassen sich relevante Regionen fokussieren und irrelevante Abschnitte ignorieren.

Anti-Flicker Filter

Der Anti-Flicker Filter dient dazu, flackernde Lichtquellen innerhalb eines definierten Frequenzbereichs zu unterdrücken. Flackernde LEDs oder Leuchtstofflampen erzeugen häufig viele unnötige Events und erhöhen so das Datenvolumen. Durch das Herausfiltern dieser Ereignisse werden nur relevante Daten erfasst. Zusätzlich gibt es eine Invert-Option, mit der ausschließlich flackernde Lichtquellen durchgelassen werden. Das ist hilfreich, um gezielt ein bestimmtes flackerndes Licht zu verfolgen.

Anti-Flicker – Beispiel (Zum Vergrößern klicken)

Event Burst Filter (TRAIL / STC)

Dieser Filter entfernt entweder redundante Events innerhalb eines Bursts oder unterdrückt das erste Event eines Bursts. Ein Burst ist eine Folge wiederholter Events mit gleicher Polarität (positiv oder negativ). Es gibt zwei Varianten: TRAIL und STC (Spatio Temporal Contrast).

Event Burst Filter TRAIL – Beispiel

Der TRAIL-Filter gibt nur das erste Event eines Bursts aus. Zusätzlich legt der Event Burst Filter Duration Reset Mode fest, ob die Dauer zur Entfernung redundanter Events nur ab dem ersten Event (First Event of Burst) zählt oder ob sie für jedes Event gilt, einschließlich der entfernten Events (Every Event). Die Dauer ist konfigurierbar. Durch das Entfernen redundanter Events senkt TRAIL die Datenrate und entlastet Systeme mit limitiertem Processing oder Bandbreite.

Event Burst Filter STC – Beispiel

Der STC (Spatio Temporal Contrast)-Filter gibt nur das zweite Event eines Bursts aus (Second Event of Burst Only) oder das zweite Event bis zum Ende des Bursts (Second Event of Burst to End). Diese Einstellungen eignen sich, um sich auf signifikante Änderungen zu konzentrieren und redundante Events zu ignorieren.

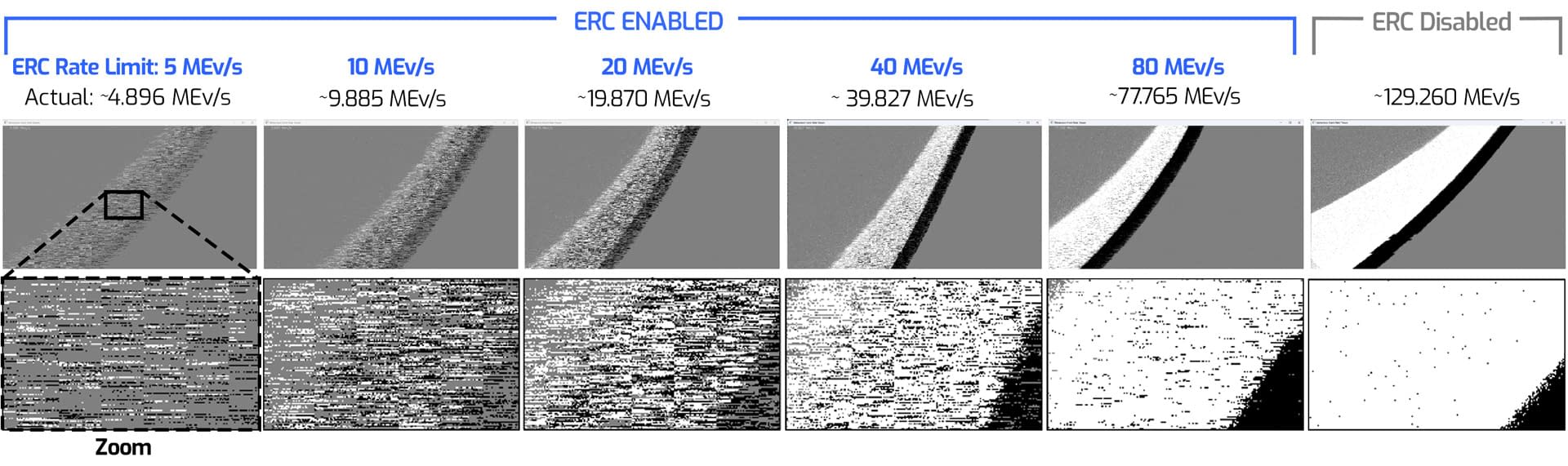

Event Rate Control (ERC)

Die Event Rate Control (ERC) begrenzt die Ausgabe-Eventrate, indem bei Bedarf Events verworfen werden, um unter einem Zielwert zu bleiben. Das erfolgt in jedem Referenzzeitraum von bis zu 200 µs nach Anti-Flicker und Event-Filtern. Danach werden die Event-Daten in EVT 3.0 kodiert. Das Verhältnis zwischen Event-Rate und Datenrate hängt von weiteren Kameraeinstellungen und der Szene ab, weshalb sich die Datenrate nicht immer exakt einstellen lässt.

Die Triton2 EVS ist für die Anbindung an den Host-PC mit 2.5GigE ausgelegt; diese Bandbreite bietet die größte Robustheit gegenüber Event-Spitzen. Bei extremen und anhaltenden Kontrastspitzen kann die Datenbandbreite dennoch überflutet werden. Selbst bei 2.5GigE hilft dann ein ERC-Limit als Sicherheitsnetz gegen unerwartete Bildlatenz, Link-Überlauf oder eine Kameratrennung durch Event-Spitzen.

Fazit

Dieses Tech Brief erklärt die Arbeitsweise der Event-basierten Triton2 EVS und beschreibt zahlreiche Funktionen zur Feineinstellung der Event-Daten für anwendungsspezifische Ergebnisse. Durch das Tuning lässt sich zudem das zum PC übertragene Datenvolumen optimieren, was CPU- und Speicherlast reduziert. Nach der Feineinstellung können Nutzer mit dem Arena SDK oder dem Metavision SDK weitere kundenspezifische Verarbeitungen zur Analyse und Verbesserung der Daten durchführen. Weitere Informationen finden Sie auf der Triton2 EVS Produktseite.

Quellen:

Sony: Event-based Vision Sensor(EVS)Technology

Sony: Event-based Vision Sensor (EVS) | Products & Solutions

Prophesee: Metavision SDK Documentation

A 1280×720 Back-Illuminated Stacked Temporal Contrast Event-Based Vision Sensor with 4.86µm Pixels, 1.066GEPS Readout, Programmable Event-Rate Controller and Compressive Data-Formatting Pipeline

How Neuromorphic Image Sensors Steal Tricks From the Human Eye

Retinomorphic Event-Based Vision Sensors: Bioinspired Cameras With Spiking Output

Latency Asynchronous Temporal Contrast Vision Sensor